作者 |德新

編輯 |王博

7月27日上周末,蔚來舉辦第二屆NIO IN。

李斌說,2023年的第一屆NIO IN像是一個大綱,第一次對外完整展示了蔚來布局的12大技術領域。

而這屆,更像第一個交付的章節。它重點展示了5項階段性的進展:

自研智駕芯片神璣NX9031流片成功;

整車操作系統天樞SkyOS全量上線;

Banyan3.0今年將上線,推出多個NOMI智能體;

智駕世界模型NWM,將在四季度開始推進量產工作;

二代NIO Phone發布。

在蔚來第二、第三品牌車型上市前,蔚來多年投入的自研,終于開始逐漸顯現出一些成果。

其中,在智能駕駛領域,從模塊化的智駕方案,向端到端大模型的切換成為今年最重要的技術風潮。未來一周內,小鵬、理想等都將公布各自在端到端智駕上的進展,蔚來率先出牌。

蔚來CEO李斌、蔚來智能駕駛研發副總裁任少卿,向我們完整闡述了蔚來在智駕上做端到端的思考。

總地來說,自研芯片加上世界模型,再加上群體智能,是蔚來智駕大模型的核心框架。

開場不久,李斌就從兜里掏出已經流片回的神璣NX9031,現場掌聲不斷。

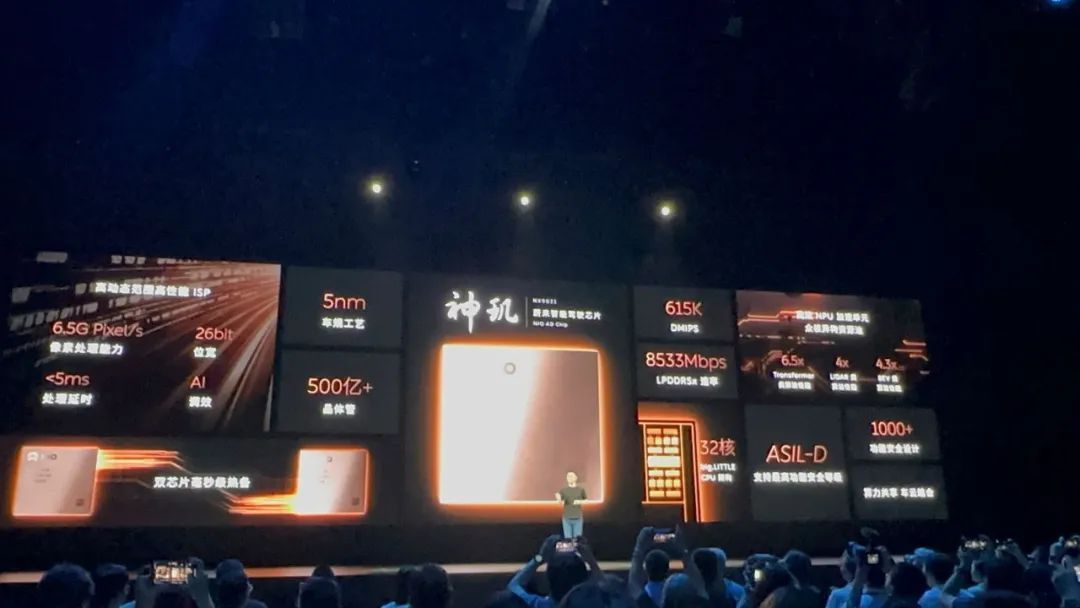

蔚來稱,這是「全球首顆車規5nm高性能智駕芯片」。

實際上,神璣NX9031幾個月前已經流片回來,團隊測試下來,「效果比預期的還要好」。

蔚來此前曾經提到神璣NX9031的定位是「一顆頂4顆(OrinX)」。這次,他們公布了更多9031的參數特征:

32核CPU,采用big.LITTLE大小核架構,CPU算力達到615K DMIPS;

NPU加速單元,Transformer類算法性能提升6.5倍,LiDAR類算法性能提升4倍,BEV類算法性能提升4.3倍;

ISP最高可達6.5G Pixel每秒的圖像處理能力;

算力共享、車云結合。

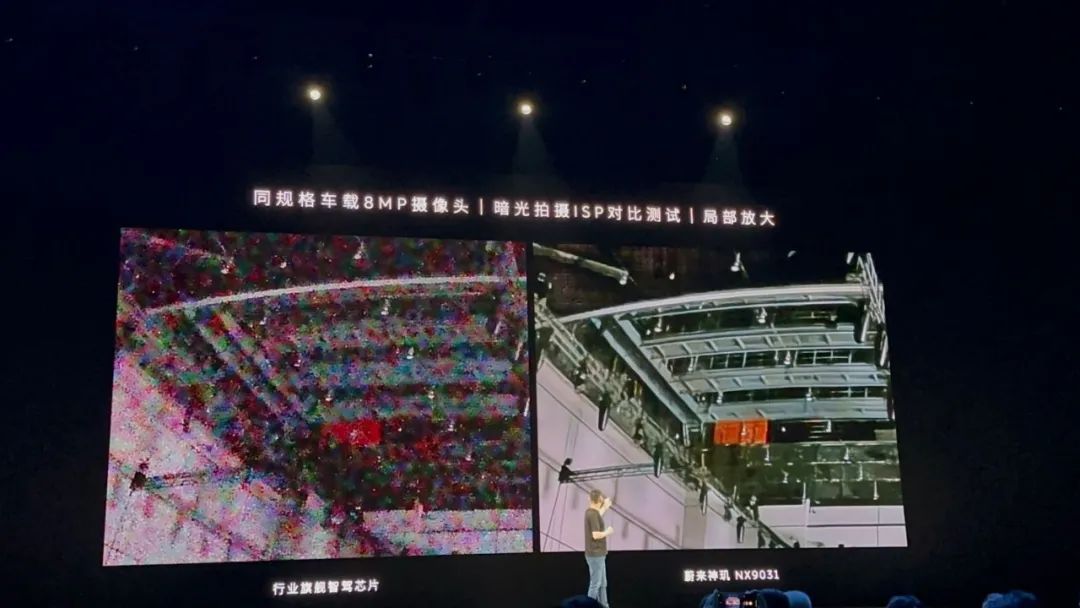

現場,蔚來還「小試牛刀」,展示了一下神璣上自研ISP在惡劣光線條件下的處理能力。

9031上ISP的高處理位寬配合降噪算法,能提供很高的動態處理范圍,從而使暗光下圖像細節更豐富,更容易看清幾百米外的標識、細小物體。

現場實拍的神璣NX9031和行業旗艦智駕芯片的圖像處理對比,基于8百萬像素攝像頭

蔚來提到的「一顆頂四顆」,是指從AI算力和ISP等主要指標上,至少有4倍以上的性能提升。

目前已經官宣的第一款搭載神璣NX9031的車型將是ET9,ET9將在明年交付。

不過,李斌也提到,「(芯片)它的作用,要明年的一季度才可以發揮出來。即使芯片上車了,依托于新的架構體驗要落地也是需要時間,期望值要管理好。」

這可能也意味著,在NT3這代平臺上,蔚來自研的神璣和第三方的計算芯片可能要并行一段時間,實現平滑過渡。

神璣NX9031是蔚來內部的芯片團隊與智駕團隊花費了幾年時間聯合定義的。它很重要的一項特性,就是為世界模型原生打造。

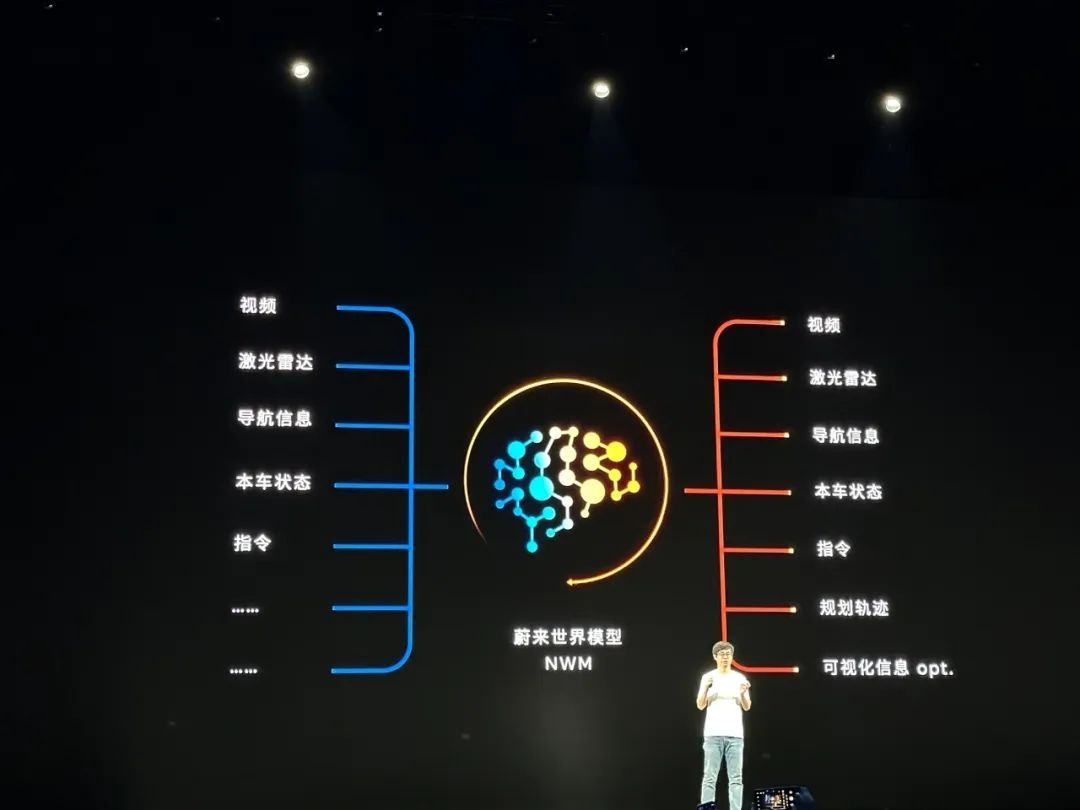

世界模型是蔚來智駕研發的下一個主要方向。

蔚來認為,一個足夠聰明的智能體,應當具備想象重建(空間理解)和想象推演(時間理解)的能力,而端到端的模型,不必然具備這兩個核心能力。

因此智駕有端到端的模型還不夠,核心是搭建世界模型。

蔚來世界模型(NIO World Model,簡稱NWM),去年已經開始規劃,但當時的NIO IN還不太成熟。

目前,NWM具有生成2分鐘長度視頻的能力,這已經超過了目前業界大部分AIGC視頻生成軟件。

2分鐘的視頻長度,可以用來預測未來2分鐘內將發生的駕駛場景;在軌跡規劃方面,MWM目前每0.1秒能生成216種可能的軌跡,而每0.1秒后再根據環境動態重新生成216種軌跡,讓系統選出最佳的駕駛策略。

李斌說,NWM這幾個月的進展非常快,是「躍遷式的,幾個月前還只能生成幾十秒」。2分鐘意味著即使開得很慢(30公里/小時),也可以覆蓋到未來1公里將發生的各種駕駛情況。

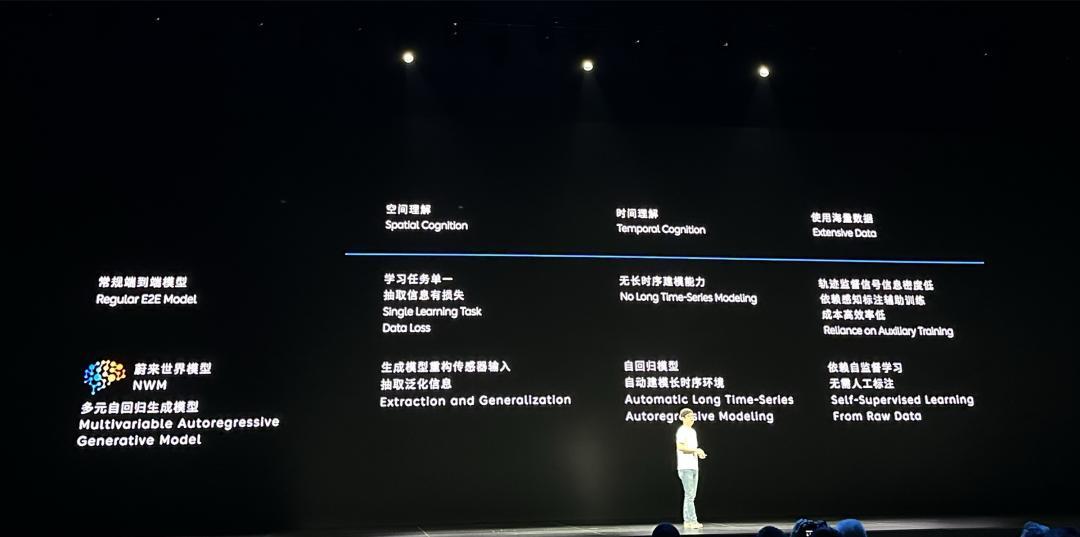

NWM是一種多元自回歸生成模型。少卿總結,NWM和常見的端到端模型的差別包括:

空間理解能力,NWM通過生成模型重構傳感器輸入泛化信息,而端到端模型學習任務單一、抽取信息有損失;

時間理解能力,NWM自回歸模型自動建模長時序環境,后者則沒有長時序建模能力;

數據要求,NWM使用無標注的數據進行自監督學習,后者依賴軌跡信號信息密度低、感知標注輔助訓練,成本高而效率低。

但訓練一個理想的世界模型,挑戰也很大:需要千萬級Clips以上的真實數據訓練、數據要豐富,想象重建的時間軸要連貫,其他還有大量的工程工作。

蔚來接下來的工作,是將NWM實現車端的部署。少卿透露,今年Q4會有機會「給大家一些體驗」。

與NWM配套,蔚來開發了仿真器NSim(NIO Simulation)。在整個數據鏈路上,車端的群體智能 + NSim理論上可以給NWM提供源源不斷的數據。

將智駕系統完全模型化,面臨兩個挑戰:

第一,世界模型需要千萬級Clips的真實數據,從哪里獲得這些真實數據;

第二,過去智駕系統的bug,可能只需要定位問題,驗證1%的模塊,而現在隨著模型的迭代,測試驗證的工作量暴增。

過去蔚來「豪橫」使用四顆OrinX的做法在業界頗有一些爭議。在大模型的時代,群體智能的設計,似乎開始發揮出更明顯的價值。

以數據收集為例,如果沒有量產車隊,一般的智駕公司持有的測試車輛最多在幾百臺級別,而幾百臺真值采集車光持有成本就達到幾億元。蔚來通過量產車隊收集數據,目前NT2平臺的車型總數在20多萬臺。

而群體智能,多用一塊OrinX的設計,使車輛不光在智駕狀態下,在非智駕狀態下也能獲取到有效數據。

蔚來在Banyan 2.6.5版本中上線的端到端AEB,其從20億公里的數據中獲取到了1萬個碰撞事故事件。實際上,在NIO IN上公布的蔚來用戶智駕領航的總里程還只有11億公里(盡管已經是目前各家中總里程最高的)。

AEB能力提升的核心挑戰是在大幅提升AEB場景覆蓋率的基礎上,不增加AEB的誤觸發,驗證覆蓋是開發中的難點。端到端AEB的驗證也使用了群體智能,4億公里分為10輪的里程驗證。

少卿說,「群體智能和生成式模型是殺手锏,可以滿足上游訓練數據的需求。」

而在測試驗證上,群體智能使得新的模型版本,可以對比人類駕駛的狀態,也可以對比過去的穩態版本,形成反饋閉環。蔚來智駕團隊告訴我們,「群體智能的驗證非常接近于實車驗證,大幅好于仿真驗證」。

在過去的4年里,智能系統的架構每年都在發生翻天覆地的變化。

無論對電子電氣架構、軟件架構還是芯片設計,高度動態的技術變化始終是巨大挑戰。

蔚來用長期的投入淌出了一條獨特的路徑。

來源:第一電動網

作者:HiEV

本文地址:http://m.155ck.com/kol/239363

文中圖片源自互聯網,如有侵權請聯系admin#d1ev.com(#替換成@)刪除。