有關無人車的定位有兩種,一種稱之為絕對定位,不依賴任何參照物,直接給出無人車相對地球坐標或者說WGS84坐標系,也就是坐標(B,L,H),其中B為緯度,L為經(jīng)度,H為大地高即是到WGS-84橢球面的高度, WGS-84坐標系是美國國防部研制確定的大地坐標系,是一種協(xié)議地球坐標系。

WGS-84坐標系的定義是:原點是地球的質心,空間直角坐標系的Z軸指向BIH(1984.0)定義的地極(CTP)方向,即國際協(xié)議原點CIO,它由IAU和IUGG共同推薦。X軸指向BIH定義的零度子午面和CTP赤道的交點,Y軸和Z,X軸構成右手坐標系。WGS-84橢球采用國際大地測量與地球物理聯(lián)合會第17屆大會測量常數(shù)推薦值,采用的兩個常用基本幾何參數(shù): 長半軸a=6378137m;扁率f=1:298.257223563。坐標系非常復雜,GPS的測量結果與我國的54系或80系坐標相差幾十米至一百多米,隨區(qū)域不同,差別也不同。

經(jīng)粗略統(tǒng)計,我國西部相差70米左右,東北部140米左右,南部75米左右,中部45米左右。在中國,國家出于安全的考慮,在地圖發(fā)布和出版的時候,對84坐標進行了一次非線性加偏,得到的坐標我們稱之為GCJ02坐標系。國內(nèi)許多地圖公司,可能是由于業(yè)務的需求,或者是商業(yè)競爭的某些原因,在GCJ02坐標的基礎上又進行了一次非線性加偏,得到了自己的坐標系統(tǒng)。百度就是這么一家公司。百度在GCJ02的基礎上進行了BD-09二次非線性加偏,得到了自己的百度坐標系統(tǒng)。

傳統(tǒng)的GPS定位精度只有3-7米,我國城市主干道單一車道寬一般是3.75米,也就是說GPS無法做到車道線級定位。在城市道路或峽谷中,精度會進一步下降。即便是美國及北約國家,民用系統(tǒng)也不可能用GPS獲得亞米級定位。GPS衛(wèi)星廣播的信號包括三種信號分量:載波、測距碼和數(shù)據(jù)碼。測距碼又分為P碼(精碼)和C/A碼,通常也會把C/A碼叫做民碼,P碼叫軍碼。P碼會再分為明碼和W碼,想要破解是完全不可能的。后來在新一代GPS上老美又提出了專門的M(Military)碼,具體細節(jié)仍處于高度保密中,只知道速率為5.115 MHz,碼長未知。北斗的定位精度目前還不如GPS。

無人車的車道線級絕對定位是個難題,無人車需要更高精度的厘米級定位。日本為解決這個問題,研發(fā)準天頂衛(wèi)星系統(tǒng)(QZSS),在2010年發(fā)射了一顆衛(wèi)星,2017年又陸續(xù)發(fā)射了3顆衛(wèi)星,構成了三顆人造衛(wèi)星透過時間轉移完成全球定位系統(tǒng)區(qū)域性功能的衛(wèi)星擴增系統(tǒng),今年4月1日將正式商用,配合GPS系統(tǒng),QZSS可以做到6厘米級定位。QZSS系統(tǒng)的L5信號頻點也是采用1176.45MHz,而且采用的碼速率與GPS在該頻點的碼速率一樣,都是10.23MHz。意味著芯片廠商在原有支持GPS系統(tǒng)芯片上無需改動硬件,只需在軟件處理上作更改就可以實現(xiàn)對Galileo、QZSS系統(tǒng)的兼容,相當于軟件實現(xiàn)上需要多搜索幾顆導航衛(wèi)星。幾乎不增加成本,而北斗系統(tǒng)是需要改硬件的,非常麻煩。因為日本國土面積小,4顆衛(wèi)星就夠了,如果換成中國或美國,可能需要35顆-40顆衛(wèi)星。

國內(nèi)大部分廠家都采用GPS RTK做絕對定位,不過RTK缺點也是很明顯的。RTK確定整周模糊度的可靠性為95~99%,在穩(wěn)定性方面不及全站儀,這是由于RTK較容易受衛(wèi)星狀況、天氣狀況、數(shù)據(jù)鏈傳輸狀況影響的緣故。首先,GPS在中、低緯度地區(qū)每天總有兩次盲區(qū)(中國一般都是在下午),每次20~30分鐘,盲區(qū)時衛(wèi)星幾何圖形結構強度低,RTK測量很難得到固定解。其次,白天中午,受電離層干擾大,共用衛(wèi)星數(shù)少,因而初始化時間長甚至不能初始化,也就無法進行測量。根據(jù)實際經(jīng)驗,每天中午12點~13點,RTK測量很難得到固定解。再次,依賴GPS信號,在隧道內(nèi)和高樓密集區(qū)無法使用。

先進的無人車方案肯定不能完全基于RTK,百度Apollo系統(tǒng)使用了激光雷達、RTK與IMU融合的方案,多種傳感器融合加上一個誤差狀態(tài)卡爾曼濾波器使得定位精度可以達到5-10厘米,且具備高可靠性和魯棒性,達到了全球頂級水平。市區(qū)允許最高時速超過每小時60公里。

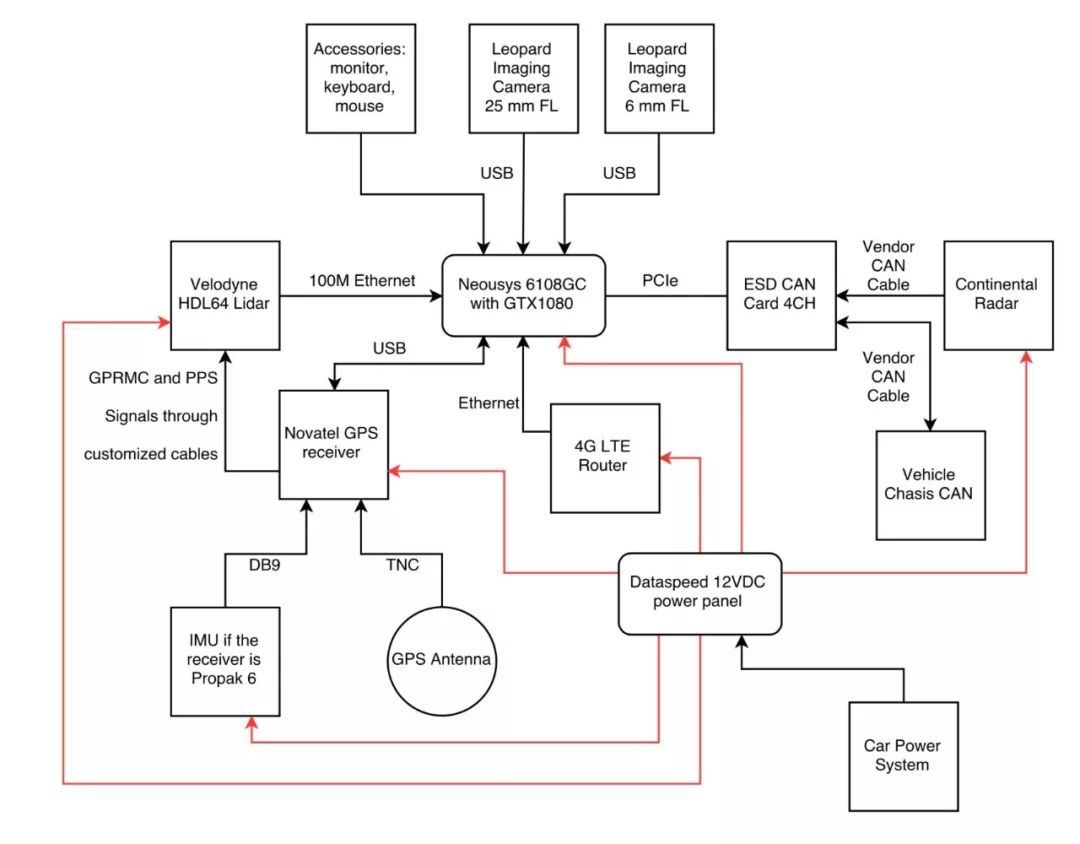

上圖為百度Apollo自動駕駛傳感器、計算單元、控制前的連接圖,計算系統(tǒng)使用臺灣Neousys Nuvo-6108GC工控機,這款工控機使用英特爾雙至強E5-2658 V3 12核CPU。主要用來處理激光雷達云點和圖像數(shù)據(jù)。

GPS定位和慣性測量單元方面,IMU 為NovAtel IMU-IGM-A1 ,GPS接收機為NovAtelProPak6。激光雷達使用的是Velodyne HDL-64E S3,通過以太網(wǎng)連接工控機,水平視野360°,垂直視野26.9°,水平角度分辨率為0.08°,距離精度小于2cm,可探測到120m的汽車或樹木。視覺系統(tǒng)使用Leopard ImagingLI-USB30-AR023ZWDR with 3.0 case,通過USB連接到工控機。使用安森美的200萬像素1080p傳感器AR0230AT和AP0202 ISP。FOV為廣角58度,有效距離大約60-70米。毫米波雷達采用的是Continental ARS408-21,連接至CAN卡。CAN卡為德國ESD CAN-PCIe/402-B4。

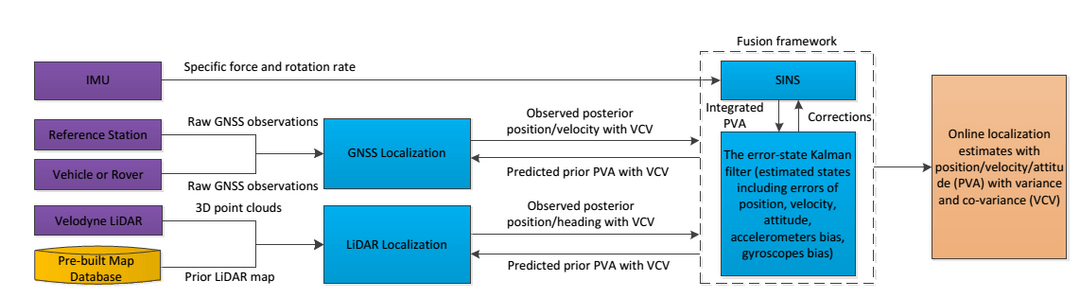

上圖為百度無人車定位模塊框架,融合了IMU、GNSS和激光雷達等傳感器(紫色),以及一個預先制作好的定位地圖(黃色)。最上層的是SINS系統(tǒng),就是Strap-down InertialNavigation。捷聯(lián)慣導系統(tǒng)是在平臺式慣導系統(tǒng)基礎上發(fā)展而來的,它是一種無框架系統(tǒng),由三個速率陀螺、三個線加速度計和處理器組成。SINS使用IMU測量得到的加速度和角速度積分得到位置、速度、姿態(tài)等,在卡爾曼濾波器的傳播階段作為預測模型;相應地,卡爾曼濾波器會對IMU的加速度和角速度進行矯正,位置、速度和姿態(tài)等誤差也反饋給SINS。RTK定位和激光雷達點云定位結果作為卡爾曼濾波器的量測更新。

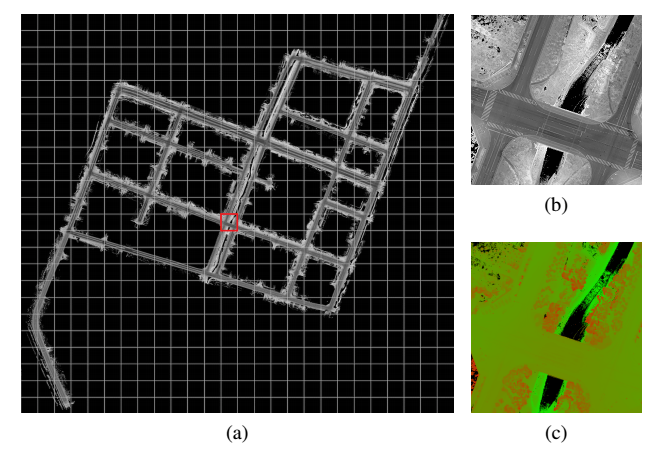

上圖為百度的激光雷達點云定位地圖。首先要提前制作一幅無人車將要行駛地區(qū)的激光雷達點云定位地圖,包含有激光雷達強度成像圖和高度分布圖,這張圖通常是地圖廠家用測繪級激光雷達完成的。目前全球絕大多數(shù)廠家包括Waymo、福特、通用等都是如此。b為激光雷達反射強度成像圖,c為高度分布圖。這張圖覆蓋范圍3.3*3.1平方公里。

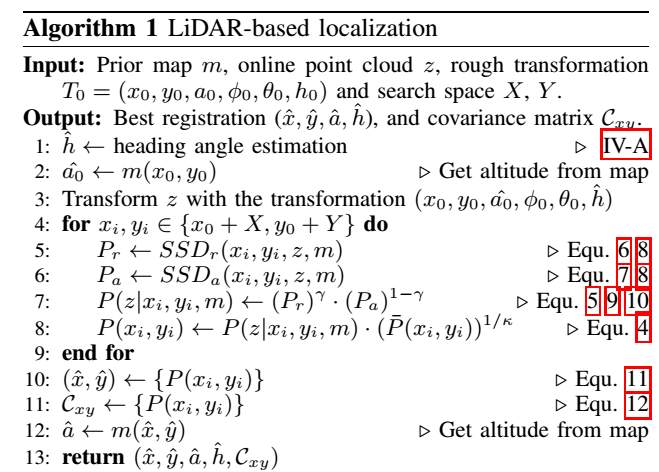

激光點云定位算法描述如下:

表面上看高精度定位很復雜,實際計算中,耗費的運算資源并不算多,基于激光雷達的運算量遠低于基于圖像的運算量。這套系統(tǒng)在將來也可以用傳統(tǒng)的汽車級SoC完成,如瑞薩的R-Car H3,恩智浦的I.MX8或S32A258C。成本有望大幅度降低。64線激光雷達也有望在未來由flash固態(tài)激光雷達取代,進而大幅度降低成本。

百度無人車定位團隊的一篇關于多傳感器融合定位的學術論文“Robust and Precise VehicleLocalization based on Multi-sensor Fusion in Diverse City Scenes”已被機器人頂級會議ICRA 2018錄用,初稿可從arXiv上下載。

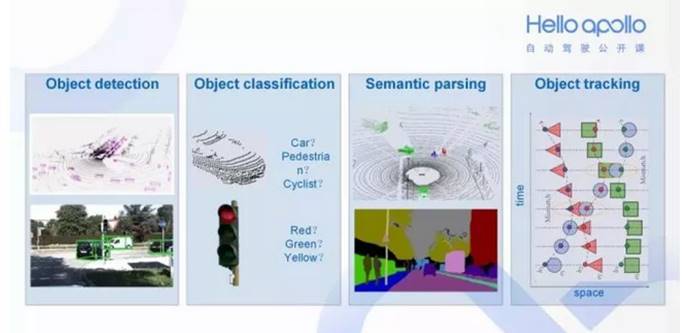

在 Apollo 中感知模塊有以下幾個職能:探測目標(是否有障礙物)、對目標分類(障礙物是什么)、語義分割 (在整幀畫面中將障礙物分類渲染)、目標追蹤 (障礙物追蹤)。

Apollo 2.0系統(tǒng)使用了多傳感器融合的方式做環(huán)境感知,攝像頭負責紅綠燈的檢測,毫米波雷達最大的作用是提供目標的運動速度,目標識別主要靠激光雷達完成的。

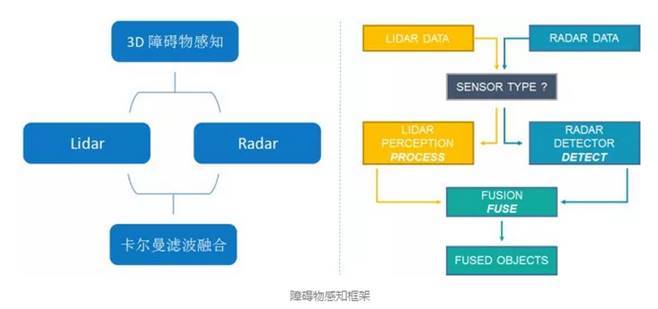

2016年10月,百度與清華聯(lián)合發(fā)表了論文Multi-View 3D ObjectDetection Network for Autonomous Driving ,地址https://arxiv.org/pdf/1611.07759.pdf,論文以激光雷達與攝像頭融合的方式做目標識別,不過在2017年5月百度發(fā)表的論文Vehicle Detection from 3DLidar Using Fully Convolutional Network,地址https://arxiv.org/pdf/1608.07916.pdf,這篇論文里放棄與攝像頭融合。在2017年10月,加入毫米波雷達融合。

2017年11月,蘋果發(fā)表論文,VoxelNet: End-to-EndLearning for Point Cloud Based 3D Object Detection,也只用激光雷達識別目標,并且與百度和清華Multi-View 3D ObjectDetection Network for Autonomous Driving做了對比,顯示出單純用激光雷達效果更好。究其原因,激光雷達數(shù)據(jù)處理速度比攝像頭要快,時間同步很有難度,兩者還需要坐標統(tǒng)一;其次是攝像頭對光線太敏感,可靠性低,遠距離尤其明顯。百度在Apollo 2.0里使用了激光雷達與毫米波雷達融合的方案。

激光雷達物體識別最大的優(yōu)點是可以完全排除光線的干擾,無論白天還是黑夜,無論是樹影斑駁的林蔭道,還是光線急劇變化的隧道出口,都沒有問題。其次,激光雷達可以輕易獲得深度信息,而對攝像頭系統(tǒng)來說這非常困難。再次,激光雷達的有效距離遠在攝像頭之上,更遠的有效距離等于加大了安全冗余。最后,激光雷達的3D云點與攝像頭的2D圖像,兩者在做深度學習目標識別時,2D圖像容易發(fā)生透視變形。簡單地說透視變形指的是一個物體及其周圍區(qū)域與標準鏡頭中看到的相比完全不同,由于遠近特征的相對比例變化,發(fā)生了彎曲或變形。這是透鏡的固有特性(凸透鏡匯聚光線、凹透鏡發(fā)散光線),所以無法消除,只能改善。而3D就不會有這個問題,所以3D圖像的深度學習使用的神經(jīng)網(wǎng)絡可以更加簡單一點。

另外,激光雷達也可以識別顏色和車道線。

無人車領域對目標圖像的識別不僅僅是識別,還包括分割和追蹤。分割就是用物體框框出目標。對于2D圖像來說,只能用2D框分割出目標,而激光雷達圖像則可以做到3D框,安全性更高。追蹤則是預測出車輛或行人可能的運動軌跡。

很明顯,3D的分割框要比2D的有價值的多,這也是Waymo和百度都用激光雷達識別車輛的原因之一。

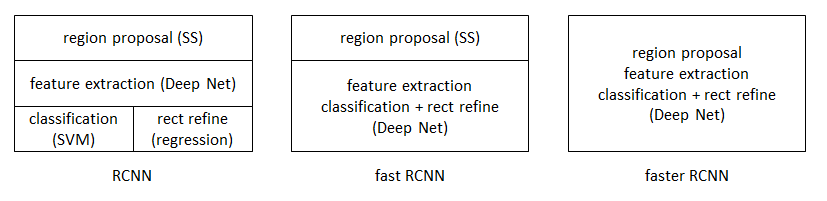

目標檢測與識別領域早期用DPM。 2013年11月,目標檢測領域公認的大神Ross Girshick推出R-CNN,2015年4月進化為Fast R-CNN,2015年6月進化為Faster R-CNN,成為今日目標檢測與識別領域公認最好的方法,也是可以完全端對端地實現(xiàn)。

激光雷達的目標檢測與識別也用FasterR-CNN。Faster R-CNN 從2015年底至今已經(jīng)有接近兩年了,但依舊還是ObjectDetection領域的主流框架之一,雖然后續(xù)推出了R-FCN,Mask R-CNN 等改進框架,但基本結構變化不大。同時不乏有SSD,YOLO等新作,但精度上依然以Faster R-CNN為最好。從RCNN到fast RCNN,再到本文的faster RCNN,目標檢測的四個基本步驟(候選區(qū)域生成,特征提取,分類,位置精修)終于被統(tǒng)一到一個深度網(wǎng)絡框架之內(nèi)。所有計算沒有重復,完全在GPU中完成,大大提高了運行速度。

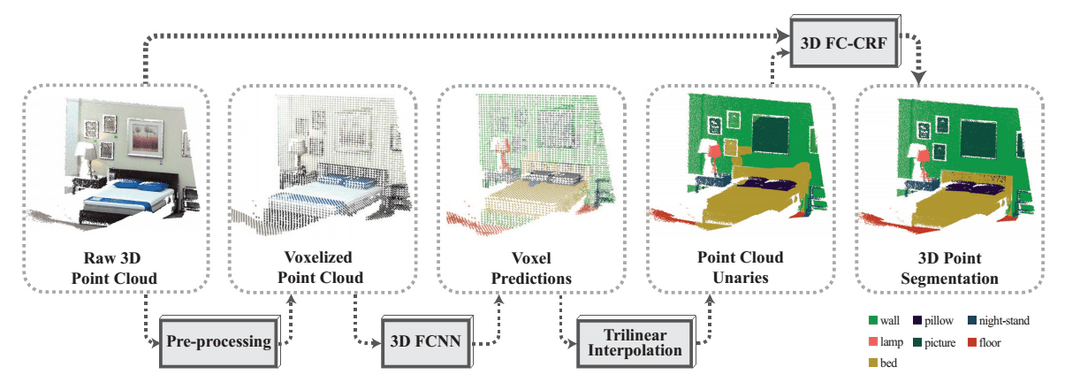

圖像語義分割可以說是圖像理解的基石性技術,在自動駕駛系統(tǒng)(具體為街景識別與理解,判斷可行駛區(qū)域)、無人機應用(著陸點判斷)以及穿戴式設備應用中舉足輕重。圖像是由許多像素組成,而「語義分割」顧名思義就是將像素按照圖像中表達語義含義的不同進行分組(Grouping)/分割(Segmentation)。語義分割有時會是最難的一部分,因為這要用到NLP自然語言處理領域的技能,而大部分玩CNN的對NLP不甚了解。

上圖為斯坦福大學的激光雷達語義分割流程圖,最后是用3D FC-CRF,也就是全連通條件隨機場,另一種常用的方法是MRF,馬爾科夫隨機場。條件隨機場用于序列標注,數(shù)據(jù)分割等自然語言處理中,表現(xiàn)出很好的效果。在中文分詞、中文人名識別和歧義消解等任務中都有應用。

百度的語義分割主要是為了更好地理解交通場景,為行為決策提供依據(jù)。低成本的無人駕駛也可以用攝像頭的2D圖像做語義分割,為無人車找出可行駛區(qū)域,光線良好的情況下可以用這種低成本的方案。

2018CES展示的Apollo2.0無人車頂部除了激光雷達外,新增了兩個攝像頭,一個長焦、一個短焦,主要目的是為了識別道路上的紅綠燈。

自動駕駛訓練數(shù)據(jù)集

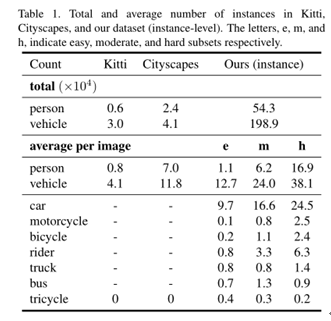

KITTI數(shù)據(jù)集由德國卡爾斯魯厄理工學院和豐田美國技術研究院聯(lián)合創(chuàng)辦的自動駕駛場景下的計算機視覺算法評測數(shù)據(jù)集。該數(shù)據(jù)集用于評測立體圖像(stereo),光流(optical flow),視覺測距(visual odometry),3D物體檢測(object detection)和3D跟蹤(tracking)等計算機視覺技術在車載環(huán)境下的性能。KITTI包含市區(qū)、鄉(xiāng)村和高速公路等場景采集的真實圖像數(shù)據(jù),每張圖像中最多達15輛車和30個行人,還有各種程度的遮擋與截斷。

Cityscapes數(shù)據(jù)集則是由奔馳主推,提供無人駕駛環(huán)境下的圖像分割數(shù)據(jù)集。用于評估視覺算法在城區(qū)場景語義理解方面的性能。Cityscapes包含50個城市不同場景、不同背景、不同季節(jié)的街景,提供5000張精細標注的圖像、20000張粗略標注的圖像、30類標注物體。

3月8日,百度正式開放ApolloScape大規(guī)模自動駕駛數(shù)據(jù)集。ApolloScape擁有比Cityscapes等同類數(shù)據(jù)集大10倍以上的數(shù)據(jù)量,包括感知、仿真場景、路網(wǎng)數(shù)據(jù)等數(shù)十萬幀逐像素語義分割標注的高分辨率圖像數(shù)據(jù),進一步涵蓋更復雜的環(huán)境、天氣和交通狀況等。ApolloScape數(shù)據(jù)集涵蓋了更復雜的道路狀況,比如單張圖像中最高可達162輛交通工具或80名行人 ,同時開放數(shù)據(jù)集采用了逐像素語義分割標注的方式。

Kitti,Cityscapes和ApolloScape的數(shù)據(jù)實例對比

對我國傳統(tǒng)車廠來說,自建訓練數(shù)據(jù)集恐怕是最大的難題,與百度合作是最好的選擇。

2018年CES上,百度發(fā)布了Apollo 2.0,搭載了百度Apollo 2.0系統(tǒng)的自動駕駛汽車將擁有簡單城市道路的自動駕駛能力。Apollo 2.0 的發(fā)布,也意味著百度整體的自動駕駛系統(tǒng)被開放出來,其中包括了云服務平臺、軟件平臺、參考硬件平臺以及參考車輛平臺。

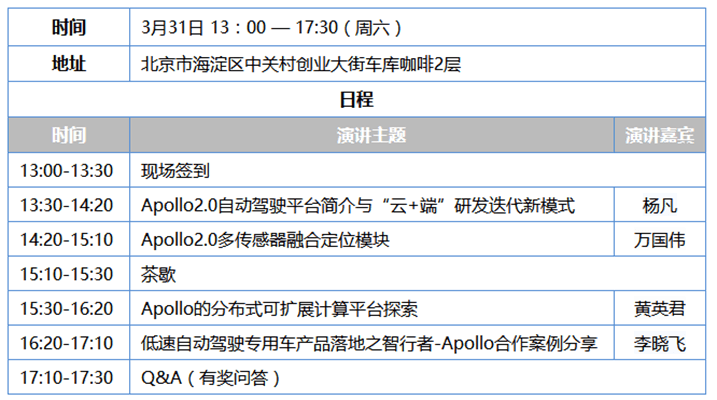

Apollo自動駕駛公開課第3期,即將于3月31日在北京舉辦,將引導自動駕駛開發(fā)者深入應用Apollo2.0。本次公開課邀請了百度自動駕駛事業(yè)部的資深工程師,以及Apollo的老用戶,一起與開發(fā)者們交流,快速掌握Apollo2.0的最新功能。

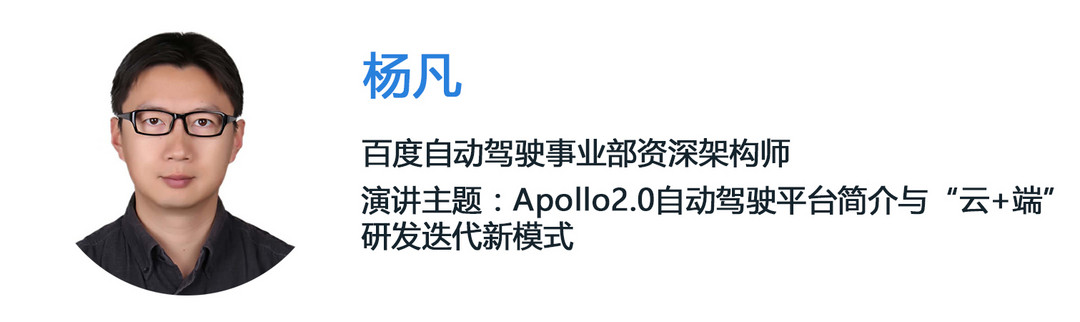

百度自動駕駛事業(yè)部資深架構師,負責產(chǎn)品化解決方案的楊凡將介紹Apollo開放平臺簡介、Apollo能力開放簡介、Apollo資源開放與研發(fā)迭代新模式、Apollo生態(tài)階段性成果。

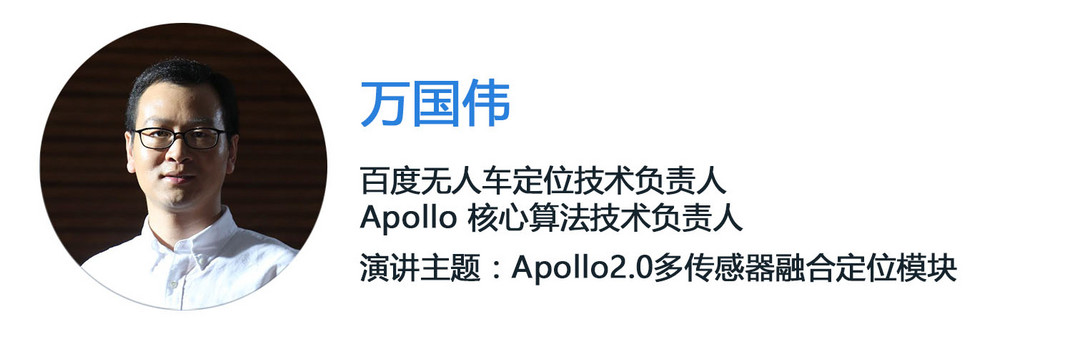

百度無人車定位技術負責人,設計并搭建了Apollo多傳感器融合定位系統(tǒng)的萬國偉將介紹《Apollo2.0多傳感器融合定位模塊》。無人車定位技術是自動駕駛領域的基礎技術之一,其難點在于如何保證高精準度和高魯棒性。Apollo2.0的多傳感器融合定位模塊自適應地使用GNSS、LiDAR及IMU等傳感器,在許多有挑戰(zhàn)的場景(例如市區(qū)、隧道等)都達到了厘米級定位。萬國偉的演講將分享定位模塊的框架,以及各子模塊的算法原理。

長沙智能駕駛研究院公司產(chǎn)品部負責人黃英君,從事智能駕駛方面總體解決方案與產(chǎn)品研發(fā)工作,將在沙龍上介紹《Apollo的分布式可擴展計算平臺探索》。黃英君的分享主要包括:在 Jetson TX2上進行Docker擴展,運行Apollo;在Apollo on Jetson TX2中配置TensorRT和VisionWorks適配,進行視覺算法優(yōu)化與加速。

智行者科技聯(lián)合創(chuàng)始人&技術研發(fā)部總監(jiān)李曉飛將在沙龍上分享《低速自動駕駛專用車產(chǎn)品落地之智行者-Apollo合作案例》,主要包括自動駕駛落地場景及應用挑戰(zhàn)、智行者AVOS系統(tǒng)研發(fā)、智行者與Apollo的技術合作三個部分。

演講嘉賓簡介

楊凡:百度自動駕駛事業(yè)部資深架構師,負責產(chǎn)品化解決方案。

演講摘要:Apollo開放平臺簡介、Apollo能力開放簡介、Apollo資源開放與研發(fā)迭代新模式、Apollo生態(tài)階段性成果。

萬國偉:百度無人車定位技術負責人,Apollo 核心算法技術負責人,設計并搭建了Apollo多傳感器融合定位系統(tǒng)。

演講摘要:無人車定位技術是自動駕駛領域的基礎技術之一,其難點在于如何保證高精準度和高魯棒性。Apollo2.0的多傳感器融合定位模塊自適應地使用GNSS、LiDAR及IMU等傳感器,在許多有挑戰(zhàn)的場景(例如市區(qū)、隧道等)都達到了厘米級定位。本次演講將分享定位模塊的框架,以及各子模塊的算法原理。

黃英君:長沙智能駕駛研究院公司產(chǎn)品部負責人,從事智能駕駛方面總體解決方案與產(chǎn)品研發(fā)工作,對Apollo的分布式擴展方面進行了探索。

演講摘要:智能駕駛的技術平臺和系統(tǒng)架構飛速發(fā)展,多個廠家都提出了自己的系統(tǒng)架構和解決方案,目前并沒有一個統(tǒng)治性的方案。Apollo集中運行感知、決策、控制模塊,對資源、實時性、可靠性需求是不同的,對計算平臺、操作系統(tǒng)、運行環(huán)境的要求也各不相同。我們分享將這些模塊進行解耦,分布式集成運行在不同的計算平臺和操作系統(tǒng)上,即在一個高可靠的雙機備份低成本平臺上運行決策與控制模塊,在多個低成本高性能技術平臺上運行感知模塊,實現(xiàn)一個分布式可擴展的解決方案。本次分享主要包括:在 Jetson TX2上進行Docker擴展,運行Apollo;在Apollo on Jetson TX2中配置TensorRT和VisionWorks適配,進行視覺算法優(yōu)化與加速。

李曉飛:智行者科技聯(lián)合創(chuàng)始人&技術研發(fā)部總監(jiān)。

演講摘要:風起云涌,自動駕駛產(chǎn)品落地之路為何困難重重?撲朔迷離,自動駕駛應用場景究竟出路何方?眾志成城,智行者和Apollo如何攜手并進?主要講述自動駕駛落地場景及應用挑戰(zhàn),智行者AVOS系統(tǒng)研發(fā),智行者與Apollo的技術合作三個部分。

來源:佐智汽車

本文地址:http://m.155ck.com/news/jishu/65264

以上內(nèi)容轉載自佐智汽車,目的在于傳播更多信息,如有侵僅請聯(lián)系admin#d1ev.com(#替換成@)刪除,轉載內(nèi)容并不代表第一電動網(wǎng)(m.155ck.com)立場。

文中圖片源自互聯(lián)網(wǎng),如有侵權請聯(lián)系admin#d1ev.com(#替換成@)刪除。